Python 웹 크롤링 - Scrapy 활용 파워볼 번호 수집(파일)

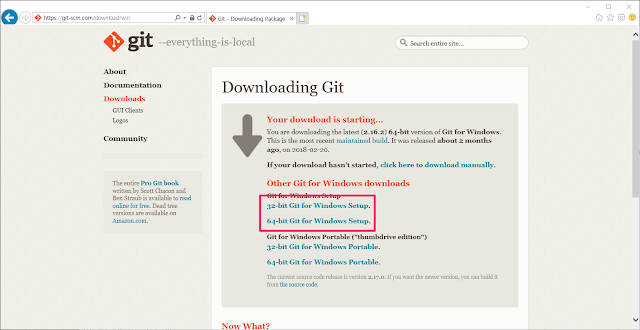

Python 웹 크롤링 - Scrapy 활용 파워볼 번호 수집 1) scrapy 프로젝트 폴더 생성 및 gitHub 등록 1-1) vscode를 사용하여 scrapy 라이브러리를 통해 프로젝트 생성 및 git-hub에 소스 업로드 하여 관리한다. - 위내용은 Windows Git 설치 및 GitHub 활용방법 을 통해 확인 할 수 있다. 1-2) PowerBall 프로젝트 폴더 생성 및 git bashshell 에서 git init 명령으로 로컬 Repository 생성 1-3) gitHub에 원격 Repository 생성 1-4) git remote add 명령을 통해 gitHub의 원격 Repository 등록 1-5) git pull 명령을 통해 git hub에서 원격 Repository를 새로 생성 할때 만들어지 .gitignore 파일 및 README.md 파일 다운로드 후 로컬과 동기화. 2) Scrapy 프로젝트 생성 2-1) scrapy startproject PowerBall(프로젝트명) 명령어를 통해 프로젝트를 생성한다. 2-2) git add 및 git commit 명령을 통해 프로젝트 파일 커밋, git push를 통해 원격저장소로 등록 -add, status - commit, push 3) 크롤링 목적 및 대상확인 3-1) 크롤링 목적 : 크롤링 공부 크롤링 대상 : PowerBall 당첨번호 - http://m.nlotto.co.kr/gameInfo.do?method=powerWinNoList&nowPage=1&searchDate=20180525&calendar=2018-05-25&sortType=num ...