Python 웹 크롤링 - Scrapy 설치

Python 웹 크롤링 - Scrapy 설치

1) 웹 클롤링(web crawling)

1-1) 특정목적을 위해 웹페이지 상의 정보를 주기적 또는 한시적으로 수집 하기 위한 작업

2) Scrapy의 사용

2-1) 파이썬에는 크롤링을 지원하기 위한 대표적인 라이브러리로 Beautifulsoup과 Scrapy가 있음 두 라이브러리의 특징은 대략 다음과 같음

- scrapy : 스크랩 과정(크롤링 -> 데이터처리)이 단순 함

- Beautifulsoup : 마크업 언어 처리 강점, UTF8 자동 인코딩 자동처리, 파서의 역활이 큼

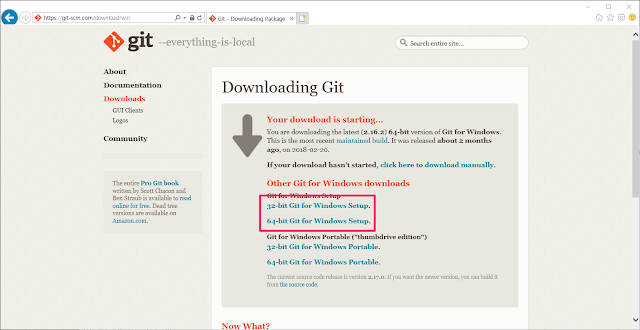

3) Scrapy 설치

3-1) 아나콘다를 설치 하여 Python을 설치 하였다면 conda 명령을 사용 conda-forge 채널을 통해 간단하게 설치가 가능하며 반면에 이미 Python 패키지 설치에 익숙 하다면 PypI를 통한 설치도 가능하다.

자세한 내용은 아래 사이트에서 확인가능하다.

scrapy의 경우 python 3.x를 지원하지 않으므로 2.x의 새로운 가상환경을 만들어서 사용해야 한다. 이유는 3.x dictionary에 특정메소드(iteritems()) 대신 items()를 상용하게 되어서 이다.

scrapy의 경우 python 3.x를 지원하지 않으므로 2.x의 새로운 가상환경을 만들어서 사용해야 한다. 이유는 3.x dictionary에 특정메소드(iteritems()) 대신 items()를 상용하게 되어서 이다.

3-2) conda 명령어로의 설치

>> conda install -c conda-forge scrapy

해당 명령어 실행시 conda의 최신번전을 update 할 것이냐고 물어 보는 경우 y를 선택 후 계속 진행 한다.

- 가상환경에 설치 하려면 해당 명령을 통해 가성 환경으로 접속 후 설치한다.

>> conda env list : 환경설정 list

>> activate 환경명 : 가상환경 활성화

- 가상환경에 설치 하려면 해당 명령을 통해 가성 환경으로 접속 후 설치한다.

>> conda env list : 환경설정 list

>> activate 환경명 : 가상환경 활성화

댓글

댓글 쓰기